Con ChatGPT Health, OpenAI compie un passo formale in un territorio che gli utenti avevano già occupato da tempo: l’uso dell’intelligenza artificiale per comprendere meglio la propria salute. La differenza, questa volta, è strutturale. Non si tratta più di domande generiche fatte a un chatbot, ma di uno spazio dedicato, separato e progettato esplicitamente per gestire informazioni sanitarie personali all’interno di ChatGPT.

L’annuncio segna un cambio di approccio netto. OpenAI riconosce che la salute è ormai uno dei principali casi d’uso della piattaforma e decide di costruire un perimetro tecnico e concettuale specifico, invece di continuare a trattare questi contenuti come una semplice estensione delle conversazioni generiche.

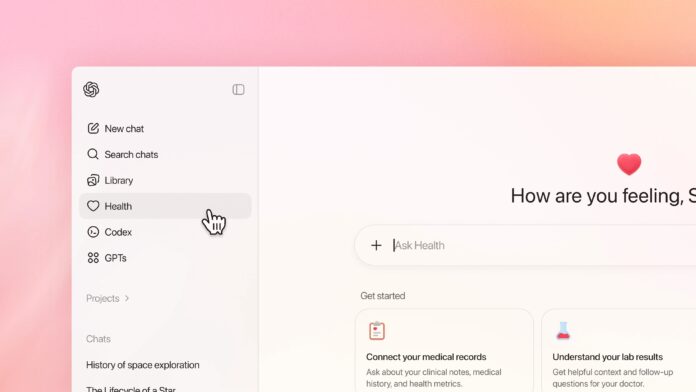

ChatGPT Health: uno spazio separato per i dati più sensibili

ChatGPT Health nasce come una sezione distinta dell’esperienza ChatGPT. Non è una semplice modalità o un preset di risposta, ma un ambiente dedicato in cui le conversazioni sulla salute, i dati caricati e le connessioni con servizi esterni vengono mantenuti isolati dal resto delle interazioni.

Questo isolamento è un punto centrale del progetto. I dati sanitari inseriti dall’utente non confluiscono nella memoria generale del modello e non vengono utilizzati per l’addestramento dei sistemi di uso comune. Dal punto di vista tecnico, OpenAI parla di controlli di accesso dedicati e di protezioni aggiuntive per informazioni che, per loro natura, rientrano nella categoria dei dati più sensibili.

È una risposta diretta a una realtà già consolidata: milioni di persone usano strumenti di AI per interpretare referti, capire esami del sangue o orientarsi tra sintomi e diagnosi. Finora lo hanno fatto in uno spazio non progettato per questo scopo. ChatGPT Health prova a colmare questo vuoto.

Dalla domanda generica al contesto personale

Il vero salto non è la capacità di rispondere a domande mediche, che esisteva già, ma la possibilità di farlo partendo da un contesto personale strutturato. ChatGPT Health consente di integrare informazioni come risultati clinici, parametri di attività fisica, dati nutrizionali e cronologie sanitarie, creando una base informativa coerente su cui l’AI può ragionare.

In questo scenario, l’intelligenza artificiale non si limita a spiegare cosa significhi un valore fuori range, ma può aiutare l’utente a collegare dati diversi nel tempo, evidenziare trend e preparare domande più mirate da portare al medico. È un ruolo di supporto cognitivo, non di decisione clinica.

Ed è qui che OpenAI insiste su un punto chiave: ChatGPT Health non fa diagnosi, non prescrive terapie e non sostituisce il professionista sanitario. L’obiettivo dichiarato è migliorare la comprensione e la qualità delle conversazioni tra paziente e medico, non eliminarle.

Un confine sottile tra supporto e illusione di competenza

Il confine, però, è delicato. Un sistema che parla con sicurezza, che ha accesso a dati personali e che fornisce spiegazioni articolate rischia di essere percepito come più competente di quanto sia realmente. OpenAI lo sa e prova a mitigarne l’effetto con limitazioni esplicite e messaggi di contesto, ma il rischio non scompare per decreto.

L’accuratezza dell’AI in ambito sanitario resta variabile. Anche quando le informazioni sono corrette, possono essere incomplete, mal contestualizzate o inadatte a un caso specifico. La medicina non è solo interpretazione di dati, ma valutazione clinica, esperienza e responsabilità legale. Elementi che un modello linguistico non possiede.

Salute mentale: il terreno più fragile

Se l’ambito fisico è complesso, quello della salute mentale lo è ancora di più. OpenAI è consapevole delle criticità emerse negli ultimi anni, con utenti che hanno usato chatbot per affrontare solitudine, depressione o pensieri autolesivi. ChatGPT Health introduce controlli aggiuntivi, ma non può trasformarsi in uno psicologo o in uno psichiatra.

In questo contesto, l’AI può al massimo offrire ascolto, orientamento e suggerimenti generici, indirizzando verso professionisti umani quando necessario. Qualsiasi altra aspettativa sarebbe pericolosa, sia per l’utente sia per la credibilità dello strumento.

Privacy, fiducia e realtà giuridica

Sul piano della privacy, ChatGPT Health alza l’asticella rispetto all’esperienza standard, ma non crea una zona franca assoluta. I dati restano dati digitali, soggetti a normative nazionali e a possibili richieste legali. Non siamo di fronte a un sistema sanitario regolato come una cartella clinica ospedaliera, ma a una piattaforma tecnologica che cerca di avvicinarsi a quel livello di tutela.

Questo è un punto che gli utenti devono comprendere senza illusioni. ChatGPT Health migliora la gestione e la protezione dei dati, ma non elimina i rischi intrinseci del trattamento digitale di informazioni sanitarie.

Una mossa inevitabile, non una rivoluzione

ChatGPT Health non è una rivoluzione medica. È una mossa inevitabile. OpenAI formalizza un uso che esisteva già, cercando di renderlo più sicuro, più strutturato e meno ambiguo. Il valore reale non sta nell’AI che “cura”, ma nell’AI che aiuta a capire, a prepararsi e a non arrivare impreparati davanti a un referto o a una visita.

Usato con consapevolezza, può essere uno strumento utile. Usato come sostituto del medico, diventa un problema. La differenza non la fa la tecnologia, ma l’aspettativa dell’utente.